Malte Kosub macht mit seinem Unternehmen plattformübergreifende Spracherlebnisse möglich. Wir haben mit dem Voice Experten, der mit seiner Agentur von Amazon mehrfach zum Alexa Champion ausgezeichnet wurde, über Smart Speaker, die Entwicklung der Technologie und über die Voice Formel gesprochen.

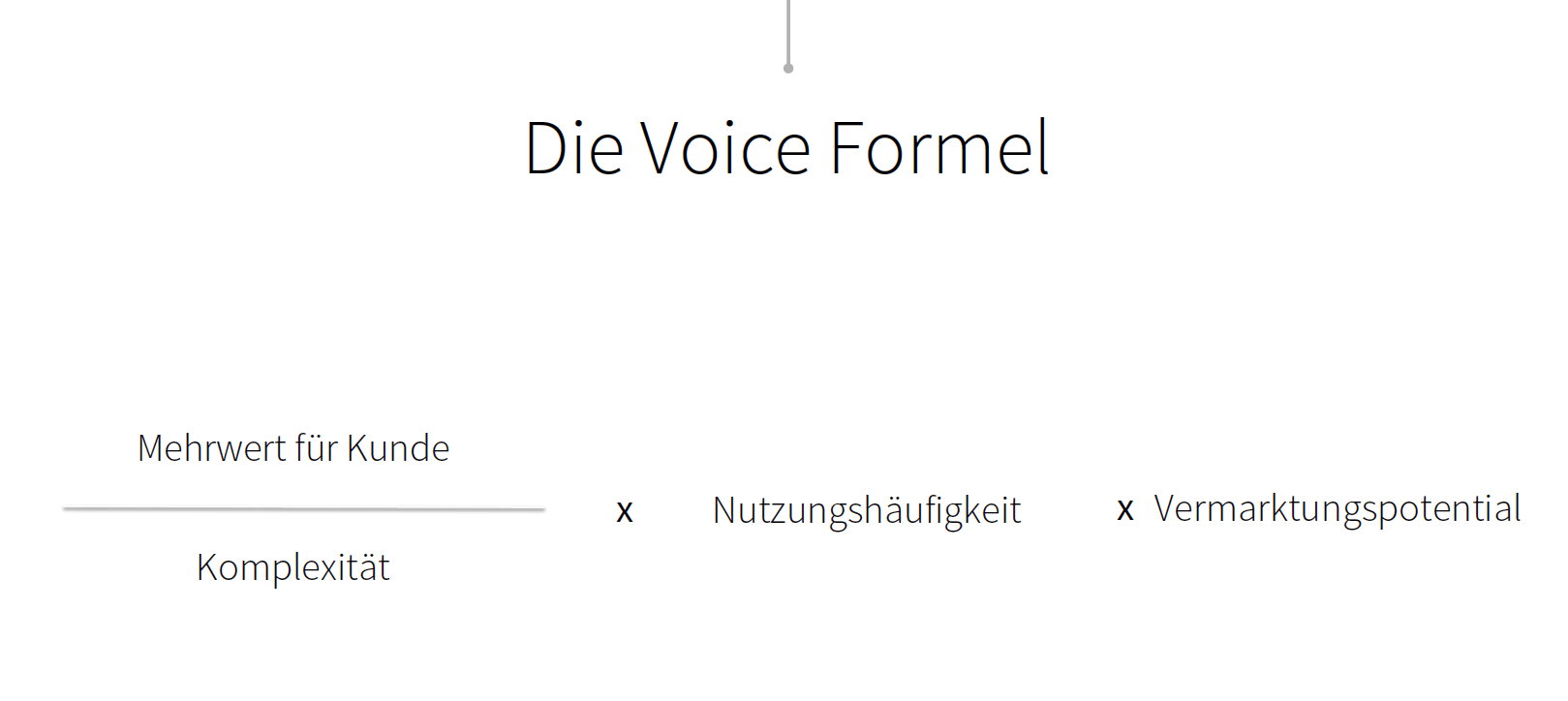

Die Voice-Formel

Malte ist ein sympathischer Kerl, der sich schon früh ehrenamtlich engagiert hat. Zu Beginn seiner Laufbahn hat er mit „Talented“ Deutschlands größten Musikwettbewerb für Schulen ins Leben gerufen. Eine Idee, die nicht nur gut ankam, sondern ihm auch eine Auszeichnung des Bundeswirtschaftsministeriums bescherte. Wer das liest würde kaum annehmen, dass sich der Wahl-Berliner mittlerweile mit einem vermeintlich emotionslosen Thema beschäftigt: Malte ist Experte für „automatisierte Kundenkommunikation“ und macht plattformübergreifende Spracherlebnisse möglich.

Lieber Malte, die Branche spricht beim Thema „Voice“ oft von einem neuen Zeitalter. Sprachassistenten wie Siri gibt es aber schon seit zehn Jahren. Was ist heute anders?

Malte Kosub: Die Technologie. Maschinell lernende Algorithmen haben statistische Verfahren abgelöst: Das hat dazu geführt, dass wir seit 2011/2012 beispielsweise einen immer schneller werdenden Anstieg der Erkennungsraten von Sprache beobachten. Wir sind heute einfach nochmal auf einem ganz anderen Level und können die Kommunikation mit Sprachassistenten immer besser weiterentwickeln.

Was können Sprachassistenten heute gut und wofür eignen sie sich dagegen weniger? Was glaubst du, wird sich auf lange Sicht durchsetzen?

Im Moment sind es einfach kurze Interaktionen, kurze Anfragen, bei denen kein langer Dialog passiert und keine Infos auf Screens geworfen werden (ich klammere Spiele über Sprachassistenten hier mal aus). Das wird sich aber bald ändern, weil die Anwendungsszenarien immer multimodaler werden. Vereinfacht gesagt heißt das so viel wie: Voice ist das Interface, über das ein Befehl gegeben wird. Das Ergebnis – das visuelle Feedback – wird dem User am TV oder auf dem Smartphone ausgespielt. Wenn sich solche Anwendungsfälle etablieren, sind dem Ganzen quasi keine Grenzen gesetzt. Der Sprachbefehl ist im Grunde die neue Tastatur, über die alles ein bisschen schneller geht. Deshalb würde ich grundsätzlich unterscheiden zwischen: Aktuell – schnelle und einfache Abfragen. Später – viel, viel mehr und neue Möglichkeiten.

Also liegt der Schlüssel eher im Zusammenspiel zwischen Stimme und Bild sowie der Interaktion zwischen verschiedenen Medien?

Für anspruchsvolle Anwendungsfälle, ja. Wann immer es kompliziert wird und ich ein visuelles Feedback brauche, könnte es heißen: „Alexa, schick mir dazu die aktuellen Infos/Angebote auf mein Smartphone“. Zum Beispiel, wenn es ums Shoppen geht. Wer sich in Sachen Fashion inspirieren lassen möchte, will die Dinge sehen. Hier bietet der Google Assistant mit seiner sehr guten Chat-Integration ins Smartphone bereits eine extrem gute Grundlage.

Du sprichst in diesem Zusammenhang von der „Voice Formel“. Kannst du sie erläutern?

Klar – die Voice-Formel lautet „Mehrwert für den Kunden“ geteilt durch „Komplexität“ mal der „Nutzungshäufigkeit“ mal dem „Vermarktungspotenzial“.

Beim „Mehrwert“ ist es wichtig, ob ich eine Funktion schneller, einfacher und natürlicher über Voice darstellen kann: „Alexa, schreib‘ mir Milch auf meine Einkaufsliste“. Wenn das funktioniert und ich hier einen hohen Mehrwert habe, teile ich das durch die Komplexität. Je höher der Mehrwert und je geringer die Komplexität, desto besser ist das Potenzial. Damit einher geht eine hohe Nutzungshäufigkeit, die ich als Anbieter identifizieren muss. Und wenn ich es darüber hinaus noch schaffe, die Sprachanwendung an meine Kunden zu vermarkten – ihnen also zu erzählen, wie sie mit den Anwendungen umzugehen haben – habe ich eine gute Voraussetzung geschaffen.

Glaubst du, dass wir in ferner Zukunft wirklich tiefgehende Diskussionen mit Maschinen führen können?

Die Diskussionen beziehungsweise Dialoge mit Sprachassistenten werden durch die Anreicherung mit dem richtigen Kontext und den passenden persönlichen Daten sicherlich immer anspruchsvoller. Wann wir allerdings tiefgehende philosophische Diskussionen mit einem Sprachassistenten machen können, ist schwer vorauszusehen. Da sollten wir in 20 bis 30 Jahren noch mal drüber sprechen. Wer weiß – das heutige exponentielle Wachstum der Technologien ist so rasant, dass niemand verlässlich vorhersagen kann, wann was eintreffen wird. Wer hätte vor zwanzig Jahren geahnt, wo wir heute stehen…

Kommen wir zurück in die Gegenwart. Warum sind die Skills oder Actions von Amazon, Google und Co. vor allem fürs Publishing und Marketing so interessant?

Im Moment sind wir bei den Skills primär im Content Marketing unterwegs. Wir versuchen gute Inhalte, die der Nutzer täglich konsumiert, an den Mann oder die Frau zu bringen. Wir nennen das „Next Level Content Marketing“, weil wir die Sprachsteuerung tatsächlich in den Alltag der Nutzer integrieren. Alles was mit Commerce und Support zu tun hat, ist sicherlich schon zum Teil machbar, aber kein Massenanwendungsfall. Das ist beim Content Marketing etwas anderes, weil es bereits Millionen Nutzer und auch Anwendungsfälle gibt. Eigentlich ist das gar nicht so neu. Bei Medieninhalten, die täglich genutzt werden, liegt die große Chance für Publisher. Aber man muss ein bisschen unterscheiden: Audiogetriebene Publisher, also Radiosender, haben einen großen Vorteil, weil sie Audio von der Pike auf gelernt haben. Klassische Verlage müssen sich also Gedanken machen, wie sie in dieser sehr audiogetriebenen Welt bestmöglichen Content liefern.

Wie schaffe ich es denn als Anbieter, dass meine Produkte oder Services von Alexa und Co. erfasst werden? Wie wird entschieden, welcher E-Commerce-Anbieter, Publisher oder Wetterservice für das jeweilige User-Anliegen zum Zuge kommt?

Das ist eine spannende Frage. Tatsächlich gibt es beim Google Assistant – ähnlich wie beim Google Algorithmus auf Desktop oder Mobile – SEO-Mechanismen, mit denen man seine News nach oben platzieren kann. Inwiefern sich das in Zukunft ändert, wenn irgendwann deutlich mehr audiooptimierter Content vorhanden ist, werden wir sehen. Sicher werden diejenigen, die eingesprochene und gleichzeitig strukturierte Inhalte integrieren, in den nächsten ein bis zwei Jahren die besten Karten haben. Da aber die Aussprache der Sprachassistenten auch immer besser wird, kann sich das auch schnell wieder ändern. Eine klare Antwort kann ich noch nicht geben. Es gibt erste Entwicklungen und an denen muss man dranbleiben.

Sollen Publisher ihren Content jetzt also extra voice-optimieren, damit dieser funktioniert und abgerufen werden kann?

Ich glaube, das kommt auf den jeweiligen Text an. In der Regel wird ein Textbeitrag SEO-optimiert und lässt sich auch noch gut lesen. Zusätzlich wird im besten Fall ein voice-optimierter Text produziert, der sich gut vorlesen lässt. Nicht von Alexa, sondern von einem echten Sprecher. Weil das einfach viel besser klingt. Glaub mir, wenn du mal drei Minuten am Stück Alexa zugehört hast, hast du irgendwann keine Lust mehr.

Das heißt, wir zünden eine neue SEO-Stufe?

Ja, so könnte man es sagen. Im Grunde muss ich meine Inhalte für Voice optimieren. Google hat deshalb – im Moment zwar noch als Beta – den Tag „Speakable“ eingeführt. Der Content sollte hierbei Mehrwert bieten und gleichzeitig kurz sein. Hierbei sprechen Google Assistant oder Alexa aber nicht alles perfekt aus. Teilweise muss ich diese Texte daher nochmal mit SSML optimieren [Anmerkung der Redaktion: Speech Synthesis Markup Language (SSML) ist eine standardisierte Auszeichnungssprache, über die bestimmte Aspekte wie Lautstärke, Tonhöhe oder Sprechgeschwindigkeit beeinflussen werden können]. Außerdem sollte jeder damit anfangen, seine Inhalte so zu optimieren, dass sie als Featured Snippets ausgespielt werden können. Der Google Assistant nutzt die Snippets nämlich bereits jetzt, um Fragen über Voice zu beantworten. Alles Dinge, die wir nun erledigen müssen.

Vorausgesetzt das gelingt und die Inhalte sind optimal aufbereitet – wie transportiere ich die Marke als Absender mit – über Sound Logos, oder eher durch ein „presented by“?

Die ersten Unternehmen fangen bereits an, die „Voice-Persona“ zu definieren. Bei Radiosendern kennt man das unter der „Station Voice“. Wie klinge ich als Marke? Habe ich am Anfang ein Sound Logo oder ein Jingle, bin ich männlich oder weiblich, eher professionell oder nahbar? Was wird eingesprochen, was nicht? Gleich zu Anfang muss eine Strategie entwickelt werden. Das ist mit dem Corporate Design auf der visuellen Ebene vergleichbar.

Wie wird sich Deiner Meinung nach das Verhältnis zwischen klassischem Suchverhalten und Voice im Netz einpegeln?

Prognosen sagen, dass 2020 fünfzig Prozent aller Suchanfragen über Voice erfolgen werden. Das bedeutet nicht, dass sie auf der Tonspur ausgegeben werden, aber sie werden über die menschliche Stimme gefragt. Noch kann niemand mit Sicherheit einschätzen, wie sich das entwickelt – aber wahrscheinlich wird diese Zahl weiter steigen.

Lieber Malte, danke für das Interview!

Malte Kosub ist seit Anfang 2017 als Gründer und Geschäftsführer der Future of Voice GmbH für die Bereiche Marketing, Sales und Finance zuständig. Mit seinem Unternehmen ist er der Erste in Deutschland, der von Amazon als „Alexa Champion“ ausgezeichnet worden ist. Das gelang seinem Unternehmen zudem drei Jahre in Folge. Vorher gründete er das E-Commerce Start-Up Wandnotiz, das Anfang 2017 an ein mittelständiges Druckereinetzwerk verkauft wurde. Er hat Betriebswirtschaftslehre an der Universität Hamburg, in Harvard und am MIT studiert.

Alexa Skill „LECKER durchs Jahr“ ab sofort verfügbar

Ab sofort bietet das HOUSE OF FOOD den Alexa Skill „LECKER durchs Jahr“ als kostenlosen Download an. Der Skill macht insbesondere digitalaffinen Food-Freunden Spaß. Gleichzeitig ist die Anwendung auch für „Neulinge“ sehr einfach: Einmal installiert, können sich die User über das Kommando „Alexa, öffne LECKER“ Backideen vorschlagen lassen. Dafür müssen sie lediglich Rezeptarten, -namen oder bestimmte Zutaten nennen oder können sich einfach überraschen lassen. Wer beim Besuch auf LECKER.de oder beim Öffnen der LECKER-App hungrig wird: Über die Nennung der Rezeptnummern lässt sich das Rezept der Wahl auch direkt aufrufen.